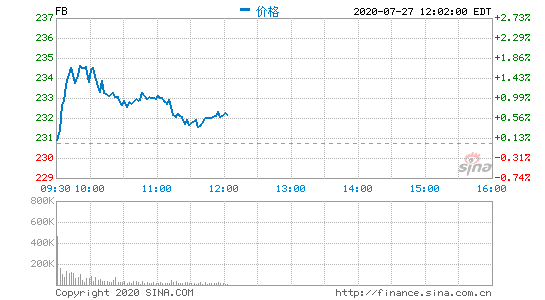

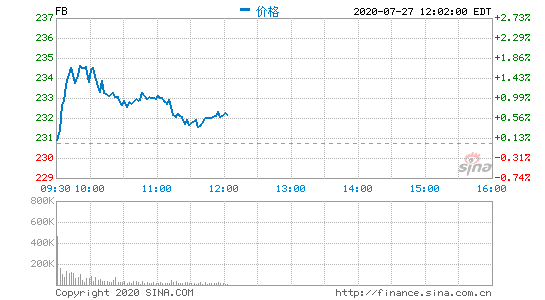

北京时间7月27日晚间消息,Facebook今日宣布,将推迟发布2020年第二季度财报,因为原定日期与公司CEO马克·扎克伯格(Mark Zuckerberg)出席国会听证会的日期有冲突。

Facebook原计划于7月29日发布第二季度财报,但 新消息显示,Facebook CEO扎克伯格将于7月29日出席美国众议院的一场听证会。为了避免冲突,Facebook今日宣布,将第二季度财报发布日期推迟 至7月30日。

Facebook originally planned to release its second quarter results on July 29, but the latest news shows that Facebook CEO Zuckerberg will attend a hearing in the US House of Representatives on July 29. To avoid conflict, Facebook announced today that it would postpone the release date of its second quarter results by one day to July 30.

美国众议院司法委员会(HRJC)下属的反垄断小组原定于7月27日举行这场听证会,但由于该日期与已故议员、黑人民权先驱约翰·刘易斯(John Lewis)的追悼会日程冲突,决定推迟到7月29日举行。

HRJC年6月,HRJC宣布对Facebook、亚马逊、Alphabet和苹果进行反垄断调查。反垄断小组将询问Facebook、亚马逊、Alphabet和苹果的CEO,以调查这些公司的商业行为是否损害了较小的竞争对手。

这些公司CEO的证词将是调查完成前的 后一步,预计调查将产生新的立法提案,以改革和规范数字市场。知情人士称,HRJC可能会在今年夏末或初秋公布针对这四大科技公司的反垄断指控,并就如控制它们的市场地位提出建议。

The testimony of CEOs of these companies will be the last step before the investigation is completed, and it is expected that the investigation will produce new legislative proposals to reform and regulate the digital market. Hrjc may announce antitrust charges against the four technology companies in late summer or early autumn this year and make suggestions on controlling their market position, people familiar with the matter said.

分析人士称,届时这四大科技公司的CEO们将为自己辩护,称他们的公司面临激烈的竞争,并驳斥其公司占据主导地位的说法。今日还有报道称,这些CEO还将以“爱国”为由,称这些企业的成功有益于美国的发展。

Facebook的“后IDFA时代”计划:关闭针对iOS14的Audience Network?

Facebook已经如火如荼的为广告商们寻找解决iPhone限定IDFA的防范措施,这一全过程并不是那麼甜美,可是务必那样开展下来。

…

与扎克伯格听证会冲突 Facebook推迟发布第二季度财报

北京时间7月27日晚间消息,Facebook今日宣布,将推迟发布2020年第二季度财报,因为原定日期与公司CEO马克·扎克伯格(Mark …